您好,我个人的服务器英伟达显卡型号是3090ti,cuda版本是11.6。在您提供的docke镜像中训练focs模型时候,出现了torch和cuda版本不一致的问题。因此我卸载了原本安装hat包时候配置的torch,重新安装了torch为1.9.1+cu111。但是,出现了以下截图的问题。请问该怎么解决呢?期待您的回答。谢谢

你好,我用的3070系列显卡,cuda 11.8版本,可以正常使用,不需要调整docker镜像,咱们是否安装了英伟达的docker呢?

您好,我安装的是docker,然后也安装了NVIDIA Container Toolkit,是可以使用gpu的。

你好,进入的指令是?-

docker run -it --runtime=nvidia -e NVIDIA_DRIVER_CAPABILITIES=compute,utility \-

-e NVIDIA_VISIBLE_DEVICES=all --rm --shm-size=“15g” \-

-v “$ai_toolchain_package_path”:/open_explorer \-

-v “$dataset_path”:/data \-

openexplorer/ai_toolchain_centos_7_xj3:“${version}”

您好,进入的指令是:

docker run -it --gpus all -v /data/home/chitm02/Sunrise/horizon_xj3_open_explorer_v2.3.3_2022727:/open_explorer -v /data/home/chitm@2/Sunrise/datasets:/data/horizon_x3/data -v /data/home/chitme2/Sunrise/mycode:/data/horizon_x3/code openexplorer/ai_toolchain_ubuntu_gpu:v1.13.6

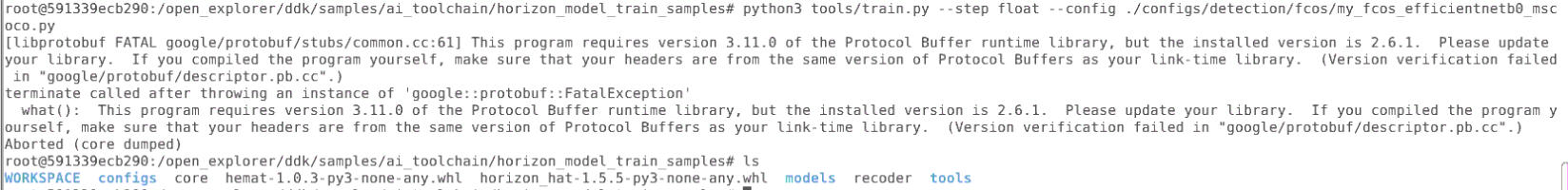

您好,我这边重新按照您的启动命令重开了一个镜像,然后也是一样训练报错。报错是:CUDA error: no kernel image is available for execution on the device 。我这边的理解是torch和cuda不匹配的问题,然后更换了torch版本。更换换成后,重新运行,报了protobuf的错误。

你好,这块需要加上,–runtime=nvidia -e NVIDIA_DRIVER_CAPABILITIES=compute,utility \

-e NVIDIA_VISIBLE_DEVICES=all